Buenas Tardes.

Tengo una consulta debido a razono diferente a lo que el libro plantea.

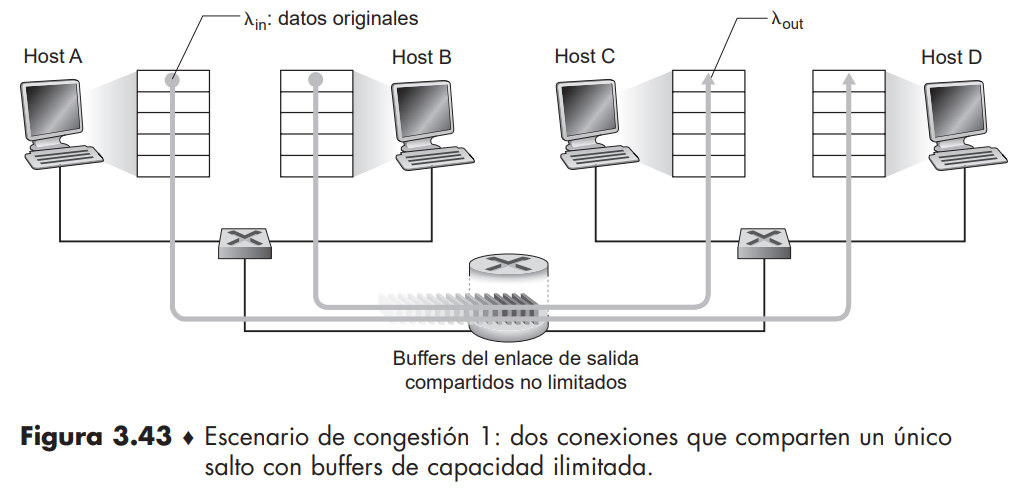

En el libro se plantea un escenario de congestión 1: dos conexiones que comparten un único

salto con buffers de capacidad ilimitada.

Mi duda es la siguiente, si "Los paquetes que salen de

los hosts A y B atraviesan un router y un enlace de salida compartido de capacidad R."

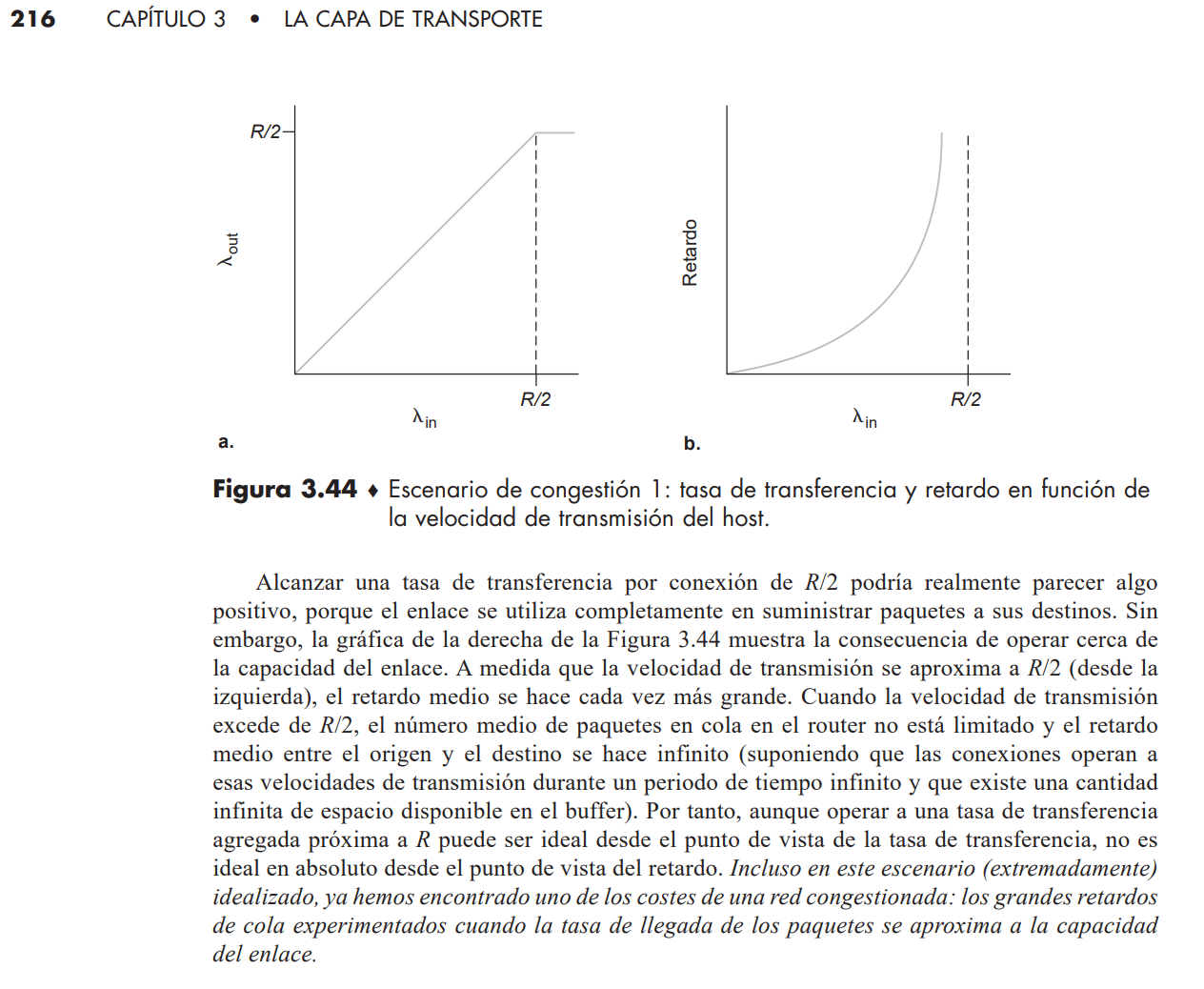

¿por qué cuando los host envían datos a una velocidad un poco menor de R/2 hay tanto retardo?

El caso de que A y B envían a velocidad mayor a R/2 lo tengo claro. Pero lo que me llama la atención es que el retardo a medida que se acerca a R/2 crezca de forma aparentemente exponencial y no lineal. Según mi interpretación debería ser un crecimiento lineal.

Muchas gracias por su tiempo

Aguardo respuesta